Por Alejandro Urueña y María S. Taboada

Magíster en Inteligencia Artificial./ Lingüista y Mg. en Psicología Social. Profesora Titular de Lingüística General I y Política y Planificación Lingüísticas de la Fac. de Filosofía y Letras de la UNT.

Los asistentes virtuales, esos supuestos “amigos” invisibles que responden a los comandos con una voz suave y eficiente, resultan ser espías inadvertidos de la cotidianeidad en nuestros hogares que, hasta la aparición pública de la IA, podíamos - sin restricciones- llamar de “propios”. Aunque pueda parecer ficción, sabemos de sobra que somos cautivos de los algoritmos que nos leen, nos predicen y, si mantenemos la inocencia, nos manupulan cada vez en “segmentos más extensos de los real para que se actúe de una manera o de otra”: se adueñan sigilosamente de parte de nuestra vida (y de nuestro hogar).

En el caso Garner vs. Amazon.com, Inc., esta distopía tecnológica ha sido sorprendida in fraganti. El 7 de julio de 2025, el Juez Robert S. Lasnik, desde United States District Judge en Washington, emitióhttps://fingfx.thomsonreuters.com/gfx/legaldocs/xmvjekqmzpr/Garner%20v%20Amazon%20-%20class%20order%20-%2020250707.pdf una orden que conmueve los pilares de la inteligencia artificial: concede parcialmente la certificación de clase en una demanda colectiva contra Amazon por el uso presuntamente abusivo de datos de voz recolectados por Alexa. No es un veredicto final –aún no declaran culpable al gigante de Jeff Bezos–, pero abre la puerta a que miles de usuarios exijan justicia colectiva. El caso podría encender alarmas en Argentina, donde la privacidad no es un lujo, sino un derecho en disputa. “Los demandantes alegan que tanto el almacenamiento permanente de las interacciones con Alexa como las activaciones falsas son elementos de diseño intencionales del servicio, empleados para acumular enormes cantidades de grabaciones de voz que puedan alimentarse a algoritmos y plataformas de aprendizaje automático para un entrenamiento de mejora continua.”

La sentencia no es un mazazo definitivo pero puede considerarse una llave maestra que desbloquea el litigio masivo. La “certificación de clase” (bajo la Regla 23 de las reglas procesales estadounidenses) es un mecanismo que agrupa a víctimas similares para evitar un caos de juicios individuales. Aquí, los demandantes –liderados por Kaeli Garner– acusan a Amazon de violar leyes de privacidad al grabar conversaciones no intencionadas (esos “falsos despertares” donde Alexa se activa sin que la llamen), transcribirlas, almacenarlas indefinidamente y usarlas para entrenar modelos de IA sin consentimiento ni compensación. El juez concede la certificación para una “clase de registrantes” –esos millones que sí registraron sus dispositivos Alexa–, permitiéndoles buscar proteger a privacidad: órdenes para que Amazon pare el uso de datos en algoritmos y destruya grabaciones existentes y “daños monetarios”: compensación por el “valor” de las voces “robadas”, calculado por los fragmentos de audio o “utterances” que alimentan la máquina de aprendizaje. Las cuestiones comunes predominan aquí sobre las individuales, haciendo viable un juicio colectivo: Amazon habría ocultado deliberadamente estas prácticas bajo términos de uso engañosos. Sin embargo, rechaza clases para “no-registrantes” –aquellos que nunca tocaron un Alexa pero vivieron con uno–, argumentando que probar consentimiento o el número de grabaciones requeriría indagaciones personalizadas, convirtiendo el proceso en un laberinto inmanejable.

Amazon, por su parte, no se queda de brazos cruzados. Los demandados –el coloso de Seattle y sus subsidiarias– defienden que Alexa es un prodigio de la nube: un servicio que procesaria 2.8 mil millones de interacciones semanales, almacenando datos solo para “mejorar” el reconocimiento de voz y el lenguaje natural, con opciones como “no guardar grabaciones” desde 2020 o exclusión de revisiones humanas. Alegan “consentimiento” implícito (¿quién no lee los términos finos?) y falta de “standing” (prueba de lesión real), reservando argumentos clave para un juicio sumario separado. Pero el juez ve en los “falsos despertares” un diseño intencional para cosechar datos masivos, usados en algoritmos sin pagar un centavo a los dueños de esas voces.

La “certificación de clase” es el filtro que decide si un pleito es “común” y “predominante” (donde lo colectivo supera lo individual, evitando mini-juicios por cabeza). Los “falsos despertares” son el corazón del drama: errores donde Alexa graba sin invitación, guardando “fragmentos truncados” para afinar modelos de IA –un eufemismo para acumular datos biométricos (tu voz como huella única). El “alivio injuntivo” es preventivo, como un freno de emergencia a prácticas éticamente dudosas; los “daños monetarios”, compensatorios: se valora cada “utterance” como oro digital. Y el “standing” exige lesión concreta, no hipotética –un muro que Amazon intentó erigir- pero el juez lo ve superable con revisiones de cuentas.

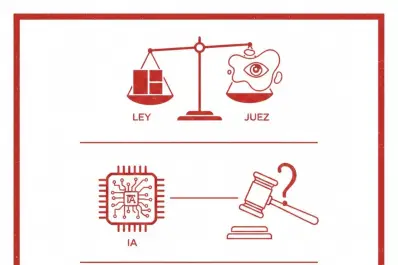

La sentencia constituye un antecedente invalorable para cuestiones similares en nuestro país. La Ley 25.326 de Protección de Datos Personales prepara el terreno (hay que actualizarla urgente): recordemos el caso de reconocimiento facial en Buenos Aires frenado por falta de consentimientohttps://www.cels.org.ar/web/2022/09/una-jueza-declaro-inconstitucional-el-uso-del-sistema-de-reconocimiento-facial-en-caba/. Si Amazon recolecta voces argentinas para su IA global, esta sentencia podría inspirar demandas colectivas bajo las normativas locales, reclamando por “uso” de datos sin pago ni consentimiento. Es un llamado a nuestros legisladores para endurecer reglas sobre biométricos, y un empujón a proyectos de “Ley de IA” en discusión desde 2024. En un país donde Alexa invade hogares, la sentencia equilibra innovación con derechos, previniendo que la “inteligencia” artificial nos deje mudos ante abusos. ¿El futuro? Más transparencia en algoritmos, o un eco de litigios que resuene desde Seattle hasta el NOA.

Esta sentencia no solo despierta a Alexa de su sueño digital, sino que nos alerta a todos: la IA escucha, pero la justicia responde.