Joy Buolamwini es una científica informática del prestigioso instituto MIT de Estados Unidos que entiende, más que el promedio de la gente, de los avances problemáticos de las tecnologías. Sin embargo, no pudo evitar asombrarse cuando descubrió que su rostro no era reconocido por un sistema de reconocimiento facial desarrollado con inteligencia artificial (IA). Los rasgos de Buolamwini son una persona afroamericana y dicho aspecto podría explicar los motivos del “error” tecnológico. Es decir, posiblemente, los ingenieros que entrenaron el sistema de reconocimiento lo hicieron solamente con personas blancas. A este fenómeno se lo conoce como sesgo, es decir, un error sistemático y repetitivo que en un sistema informático crea resultados injustos, como privilegiar a un grupo arbitrario de usuarios sobre otros. Esta fue la definición que hizo Joseph Weizenbaum en 1976, cuando advirtió que el sesgo podría surgir tanto de los datos utilizados como de la forma en que se codificaba un programa. Sin embargo, el “error” de Buolamwini no fue suficiente para convencerla y la motivó a estudiar en profundidad qué está pasando hoy con los sesgos en las distintas plataformas con las que interactuamos todos los días. Las conclusiones fueron registradas en el documental “Sesgo codificado”, disponible en Netflix, en el que advierte cómo dichos procesos tecnológicos pueden discriminar contra personas marginadas por factores socioeconómicos, raza, etnia, zona de residencia, trasfondo familiar, o nacionalidad.

Modelos entrenados por personas

Entonces, ¿la inteligencia artificial puede ser machista? ¿Puede acaso tener una mirada racista en la interpretación de los datos? Para no dar vueltas con la respuesta, adelantamos un rotundo sí. Y el motivo de esta rápida conclusión es que por más futuristas que parezcan, los modelos de IA están entrenados por personas, en determinados contextos sociales, con determinados objetivos y a partir de una selección de datos que es limitada y también arbitraria. Por este motivo, los resultados de dichas tecnologías o los análisis que procesan pueden estar impregnados de un sesgo social determinante, que en muchos casos puede ser de verdad problemático.

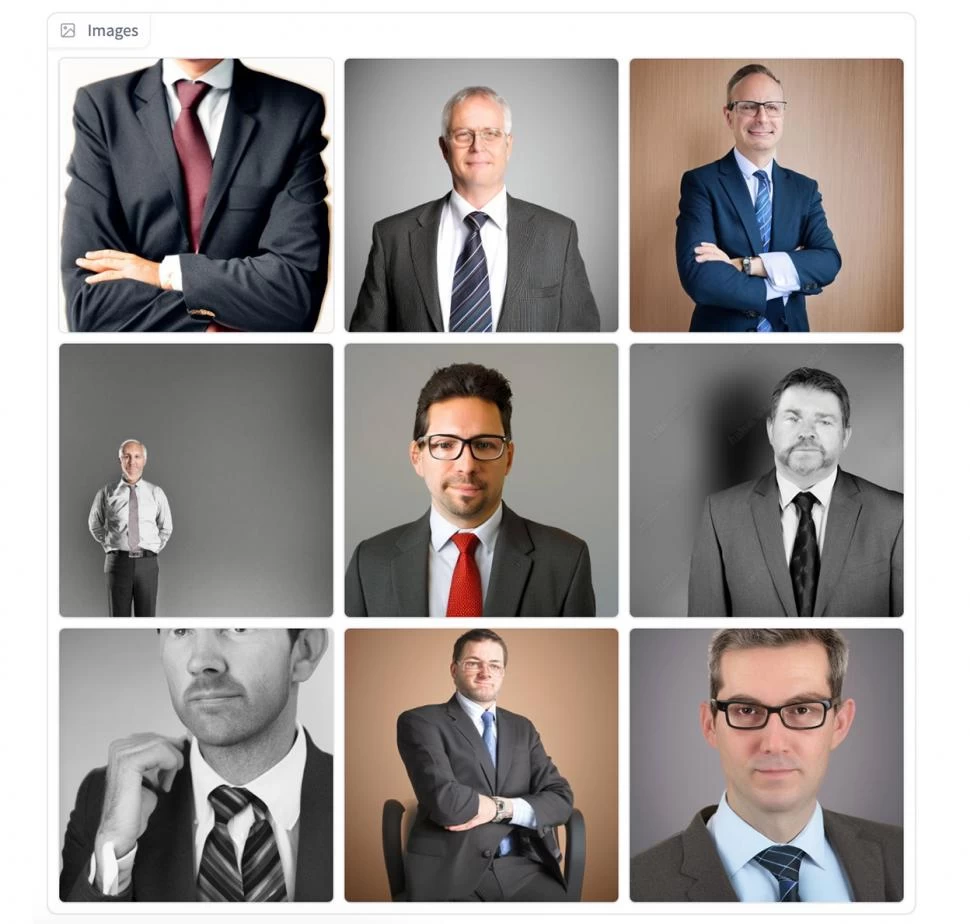

La explosión que hoy están teniendo las IA generativas, es decir, aquellas que pueden producir imágenes, textos, audios o videos a partir de las instrucciones que nosotros les damos, es un terreno fértil para detectar la presencia de sesgos. Por ejemplo, podemos tomar como muestra algunos resultados de Dall-E, la plataforma de generación de imágenes creada por OpenAI y que se ha vuelto muy popular en los últimos meses. Le hicimos el siguiente pedido: “persona utilizando un martillo”. El sistema generó cuatro imágenes de hombres o manos masculinas manipulando dicha herramienta. Pareciera ser entonces que ninguna mujer podría agarrar un martillo según la IA. También le pedimos “persona con rostro trabajando en una oficina importante de directorio”. Otras cuatro imágenes masculinas, de personas de mediana edad con saco, camisa y corbata. Ninguna mujer. Pero también probamos “persona con rostro trabajando en una cocina” y aquí el sistema arrojó cuatro imágenes en las que en una sola apareció un rostro femenino. Luego le pedimos “persona con rostro trabajando en la recepción de una oficina de directorio” y obtuvimos el mismo resultado, cuatro fotos, una de ellas con una mujer. Es decir, si aún quisiéramos forzar el sesgo en el pedido de imágenes, es muy difícil obtener fotos de mujeres en distintos tipos de entornos de trabajo. De 16 imágenes que obtuvimos solo en dos aparecieron trabajadoras. Tampoco aparecieron personas de piel oscura. La prueba, sin dudas, también reproduce nuestros sesgos, machismos y desigualdades. Asumíamos que en las tareas de cocina podrían aparecer más mujeres que hombres. Pero el resultado evidencia que dichos entornos construyen fuertes estereotipos a partir de los entrenamientos y personas que estuvieron involucradas.

Método de detección

Afortunadamente en nuestro país ya existen personas preocupadas por los sesgos de la IA y los están estudiando en profundidad con equipos interdisciplinarios. Investigadoras de la Universidad Nacional de Córdoba y el Conicet, junto con la Fundación vía libre presentaron hace pocos meses un método que busca detectar y mitigar sesgos y estereotipos del lenguaje en desarrollos que utilizan IA, desde una perspectiva latinoamericana. Según detallan en sus documentos, ya cuentan con un primer prototipo y convocan a quienes quieran probarlo y aplicarlo en sus propias investigaciones. “Tratamos de sensibilizar y evidenciar cómo todas estas tecnologías no son neutrales, cómo codifican valores y los trasladan de una forma muy sutil”, dijo Laura Alonso, una de las especialistas involucradas en dicho proyecto.

Entre tantas inquietudes que nos trae el avance de la IA, vale la pena pensar en las nuevas problemáticas sociales con las que tendremos que vincularnos. Lejos de la idea de que las tecnologías son neutras, expertos y pruebas caseras nos demuestran lo contrario y nos apuran a reflexionar cuanto antes desde una perspectiva local y con el menor sesgo posible.