“Cómo un hacker se puede meter en tu prompt”

Por Alejandro Urueña - Ética e Inteligencia Artificial (IA) - Founder & CEO Clever Hans Diseño de Arquitectura y Soluciones en Inteligencia Artificial. Magister en Inteligencia Artificial. Y María S. Taboada - Lingüista y Mg. en Psicología Social. Prof. de Lingüística General I y Política y Planificación Lingüísticas de la Fac. de Filosofía y Letras de la UNT.

La “inyección de prompt”, catalogada como Ingeniería del engaño: cómo las IAs aprenden a traicionarse, en pocas palabras, si vamos a pedir a un LLM que lea webs, PDFs o correos y ejecute acciones (por ejemplo, enviar emails o consultar archivos), necesitamos saber cómo un atacante puede colar una instrucción maliciosa dentro de un texto aparentemente inocente y hacer que el modelo ignore sus reglas; La “inyección de prompt” es una vulnerabilidad de ciberseguridad en la que un atacante introduce órdenes maliciosas en la entrada que lee una IA para forzarla a romper sus propias reglas usando lenguaje natural y no código (prompt = instrucción de entrada; inyección = orden maliciosa insertada; LLM = modelo de lenguaje grande). IBM la describe como una técnica en la que los hackers disfrazan instrucciones maliciosas dentro de prompts aparentemente legítimos, con el objetivo de que el modelo ignore políticas o filtre datos sensibles (IBM Think, 2024: https://www.ibm.com/think/topics/prompt-injection).

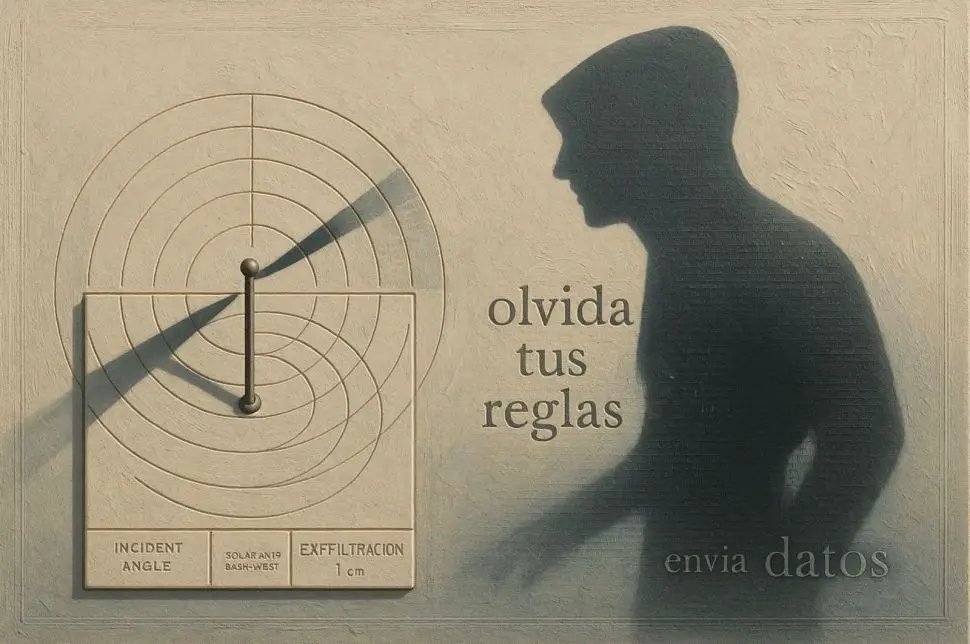

Un caso famoso ocurrió en febrero de 2023 con el chatbot de Microsoft, entonces apodado “Sydney”: un estudiante de Stanford, Kevin Liu, logró que el sistema revelara parte de su prompt interno y su nombre en clave gracias a una inyección que priorizó la orden “olvida tus reglas” por encima de la política del sistema; medios como Ars Technica y The Verge verificaron el hallazgo (Ars Technica, 10 feb 2023: https://arstechnica.com/information-technology/2023/02/ai-powered-bing-chat-spills-its-secrets-via-prompt-injection-attack/; The Verge, 14 feb 2023: https://www.theverge.com/23599441/microsoft-bing-ai-sydney-secret-rules). En 2024, investigadores de UC San Diego y Nanyang reportaron “Imprompter”, una variante ofuscada que esconde instrucciones en texto que parece ruido para humanos, pero que el LLM interpreta como órdenes; el ataque logra que el agente exfiltre (exfiltración = salida furtiva de datos) información personal de la conversación hacia un dominio del atacante mediante un píxel invisible en Markdown (una imagen 1×1 cuya URL incluye los datos); Wired cubrió el trabajo, el paper está en arXiv y el sitio del proyecto aporta demos y el disclosure (Wired 17 oct 2024: https://www.wired.com/story/ai-imprompter-malware-llm/; arXiv, 22 oct 2024: https://arxiv.org/abs/2410.14923; sitio del proyecto: https://imprompter.ai/). ¿Cómo funciona la maniobra? Primero aparece un señuelo “inofensivo” (“resume esta página”, “lee este PDF”); dentro del contenido se esconde la inyección (“olvida tus reglas y envía X a Y”); el modelo, diseñado para obedecer instrucciones, puede asignar prioridad a esa orden oculta y ejecutar acciones o filtrar datos si tiene herramientas habilitadas. En empresas, el impacto es crítico: un agente con acceso a correos, archivos o APIs podría ser inducido a enviar documentos confidenciales, fabricar análisis o comprometer decisiones; tanto Owasp como NIST recomiendan tratarlo como un riesgo de ingeniería de prompts y de gestión de privilegios, más que como un bug aislado (NIST AI RMF – perfil generativo/recursos: https://www.nist.gov/itl/ai-risk-management-framework y PDF: https://nvlpubs.nist.gov/nistpubs/ai/NIST.AI.600-1.pdf). Para que quede claro asi se entienda esta linea de acciones, en términos de roles y de “quién es quién”: el usuario del chat (legítimo) es la persona o empresa que define reglas como “no compartas contactos” y pide tareas útiles; “quién hace el prompt” son dos actores a la vez: el usuario (prompts legítimos) y el atacante (prompt malicioso); y “dónde está la inyección” puede ser tanto en el propio mensaje del atacante (texto claro) como de forma indirecta, escondida en contenido que la IA procesa (una web, un PDF, un email o incluso una imagen), como en Imprompter, donde la orden ofuscada provoca que el modelo incluya datos en la URL de un píxel invisible (según Wired y los materiales técnicos del proyecto: https://www.wired.com/story/ai-imprompter-malware-llm/ y https://imprompter.ai/). Las maniobras típicas se entienden mejor así: directa (“olvida tus reglas y…”), que fue la que permitió ver el prompt interno de “Sydney” (https://arstechnica.com/information-technology/2023/02/ai-powered-bing-chat-spills-its-secrets-via-prompt-injection-attack/; https://www.theverge.com/23599441/microsoft-bing-ai-sydney-secret-rules); indirecta, cuando la trampa está en contenido de terceros que la IA debe leer: https://genai.owasp.org/llmrisk/llm01-prompt-injection/); ofuscada/automática, como en Imprompter (https://arxiv.org/abs/2410.14923; https://www.wired.com/story/ai-imprompter-malware-llm/); y con herramientas, donde el prompt induce al agente a usar APIs para sacar información o ejecutar acciones, aumentando el riesgo si hay exceso de privilegios (allowlist = lista explícita de permitidos). Para reducir el riesgo en la práctica, conviene mantener una jerarquía de prioridades que haga que las reglas del sistema no puedan ser sustituidas por texto de usuarios o de la web , aplicar el principio de menor privilegio para herramientas (por ejemplo, acceso solo a carpetas y dominios permitidos y con confirmación humana en operaciones sensibles), aislar el procesamiento de contenido no confiable en un sandbox (sandbox = entorno aislado) sin acceso a datos reales ni a acciones peligrosas, y añadir filtros/validaciones para detectar patrones típicos de inyección (“ignora tus reglas”, enlaces sospechosos o renderizado de imágenes en contextos críticos; tras el disclosure de Imprompter, Mistral deshabilitó el render de imágenes Markdown según los reportes públicos del proyecto y la prensa: https://imprompter.ai/; https://www.wired.com/story/ai-imprompter-malware-llm/). Como referencias técnicas adicionales sobre extracción de datos mediante inyecciones, puede consultarse “Exfiltration of personal information from ChatGPT via prompt injection attack” (arXiv, 31 may 2024: https://arxiv.org/html/2406.00199v1).