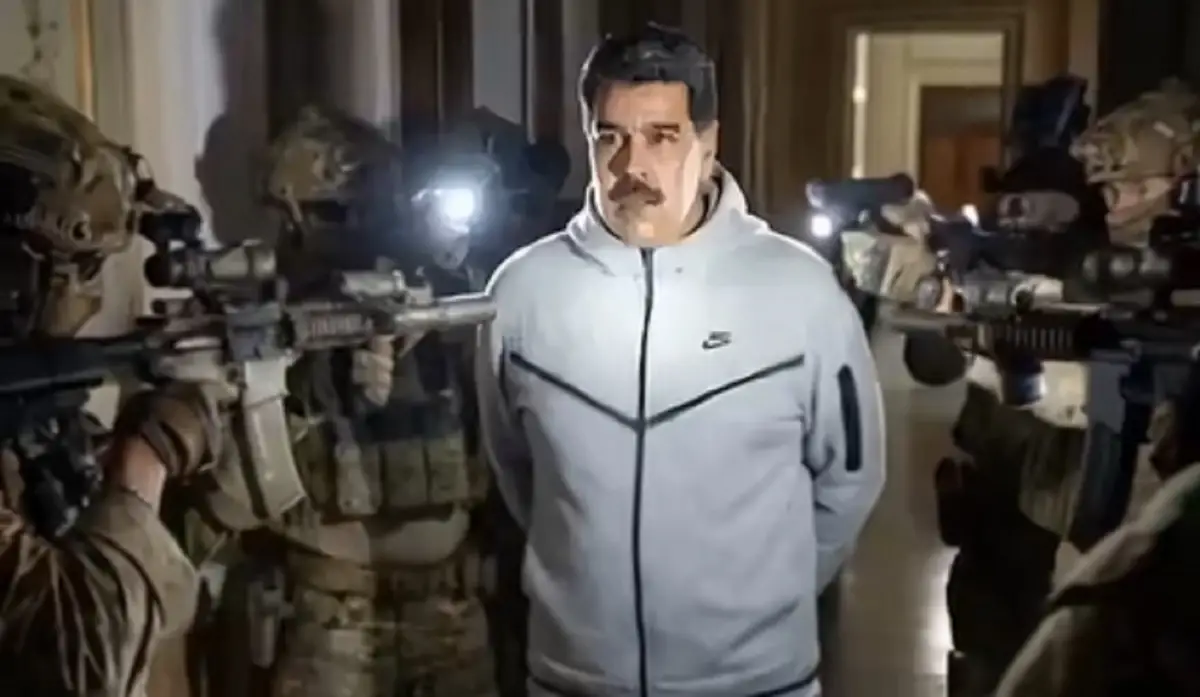

“Una imagen vale más que mil palabras”, dice el viejo refrán. Pero, ¿qué pasa cuando la imagen es una simulación perfecta, creada por algoritmos? La reciente viralización de un video falso que muestra una captura limpia, casi quirúrgica, de Nicolás Maduro, generado íntegramente por inteligencia artificial, marca el inicio de un nuevo tipo de conflicto: la guerra de narrativas en la era de la fabricación total de la evidencia visual. Estamos ante un punto de inflexión. La tecnología ya no solo distorsiona la realidad; ahora la suplanta desde sus cimientos. Y eso nos deja con una pregunta incómoda: si todo puede falsificarse, ¿en qué basamos nuestra creencia de lo real?

Millones de personas compartieron esas imágenes. En ellas, Maduro aparece dócil, escoltado sin resistencia por agentes con parches de la DEA (Drug Enforcement Administration, la agencia antidrogas de Estados Unidos). No hay gritos, ni caos. Pero esa narrativa choca brutalmente con lo que realmente ocurrió en Caracas en la madrugada del 3 de enero, según el gobierno estadounidense: explosiones, enfrentamientos y víctimas. La IA no solo mintió sobre lo que pasó; produjo una versión edulcorada y desinfectada de un evento traumático.

El video falso sobre Maduro opera como un proyectil psicológico de precisión. En un contexto como el venezolano, con flujo informativo restringido y censura estatal, ese contenido encuentra caldo de cultivo.

Para quien busca noticias en medio de la incertidumbre, un video parece ofrecer una respuesta sólida, visualmente creíble. Su propósito no es convencer a todos, sino sembrar duda, desmoralizar a unos, exaltar a otros y, sobre todo, probar los límites de resiliencia de nuestro ecosistema informativo. Es un sondeo de cuánta falsificación podemos digerir.

En medio del mar de dudas que hoy definen a las redes sociales, la detención de Maduro, retratado con los ojos vendados y bajo custodia militar, generó un fuerte debate sobre su procedencia. A pesar de que la imagen fue compartida por Donald Trump, el primer impulso global fue el de la duda, condicionado por la recurrencia con la que se utiliza la inteligencia artificial para moldear la narrativa política. Fue esa incertidumbre, sumada al estilo cinematográfico de la captura, lo que convirtió a un hecho real en un fenómeno de verificación en tiempo real, donde la veracidad debió abrirse paso entre las sombras de la desinformación digital.

El rol de chequear

Ante este tsunami sintético, el periodismo y la verificación de datos reaccionaron con rapidez y rigor. Pero su respuesta también revela la descomunal asimetría de esta nueva batalla. Mientras un equipo de fact-checkers en Venezuela necesitó horas para rastrear la marca de agua invisible de Google que confirmaba el origen en IA, el video ya había cruzado fronteras y generado reacciones incontables.

La verificación, nuestra herramienta más valiosa, corre una carrera de obstáculos en la que el daño se produce a la velocidad del clic, mientras la verdad avanza al ritmo del análisis forense.

Medios como Chequeado cumplen un rol crucial al desmontar este ecosistema paralelo de mentiras: videos de celebraciones en Santiago de Chile presentados como Caracas, imágenes de bombardeos en Tel Aviv recicladas como ataques en Venezuela, grabaciones antiguas de protestas vendidas como júbilo por la captura. Cada una de estas piezas es un ladrillo en un muro de ruido diseñado para saturar y confundir.

La aparición de estas falsificaciones en momentos de crisis señala un futuro sombrío. Ya no bastará con preguntar “¿esto es verdad?”; tendremos que preguntarnos “¿esto puede, siquiera, ser real?”. La carga de la prueba se invierte. En el fragor de un conflicto, con reportes contradictorios y emociones a flor de piel, el ciudadano común no tiene tiempo ni herramientas para buscar marcas de agua sintéticas o hacer búsquedas inversas de imágenes.

Más allá del caso concreto, todo esto nos plantea un dilema ético profundo sobre la responsabilidad de las plataformas y los creadores de la tecnología. Google, cuya herramienta Gemini fue identificada como la fuente probable del video, ha implementado marcas de agua invisibles para etiquetar contenido generado por IA. Es un paso necesario, pero insuficiente. ¿No debería ser obligatorio un sello visible e indeleble en todo contenido sintético, sobre todo cuando involucra a figuras públicas en contextos sensibles?

Hace poco, el diario estadounidense The New York Times publicó sus predicciones para 2026. Una de ellas apuntaba a un posible cansancio frente a la avalancha de contenido generado por IA, y a un giro hacia expresiones más imperfectas, más humanas. Paradójicamente, esa búsqueda de autenticidad podría generar aún más confusión. Porque hoy, la credibilidad se deposita, casi por defecto, en quien emite el mensaje con mayor autoridad percibida, o en lo que “se siente” más real. Y ahí está el riesgo: la estética aséptica de la IA, su falta de imperfecciones, puede leerse, para un ojo no entrenado, como prueba de profesionalismo, no de falsificación.

Según Meaghan Looram, directora de fotografía del periódico mencionado anteriormente, las herramientas de detección de IA son vitales a la hora de saber si una foto o un video son reales o no. Sin embargo, actualmente no existe ninguna que verifique imágenes de manera inequívoca.

La inteligencia artificial no inventó la mentira ni la propaganda; lo que hizo fue perfeccionarlas, acelerar su circulación y volverlas indistinguibles de la realidad para millones de personas.

Tal vez el verdadero desafío de esta era no sea aprender a detectar lo falso, sino reconstruir los acuerdos mínimos sobre qué consideramos real cuando la imagen dejó de ser prueba y pasó a ser sospecha.